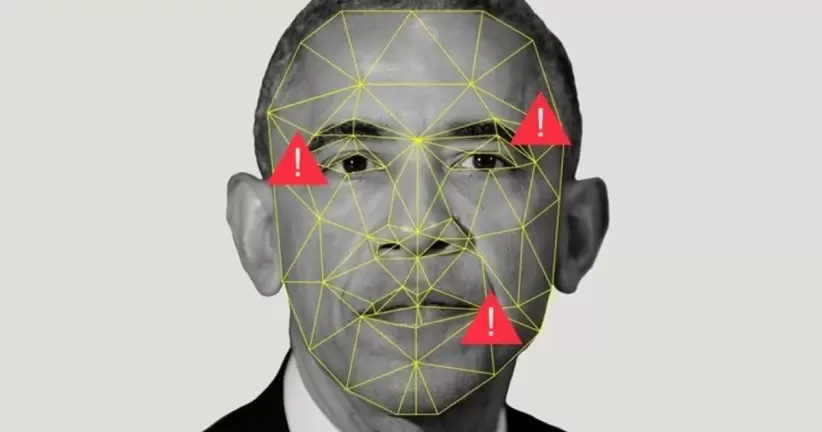

Contenido generado por inteligencia artificial, que va desde imágenes ilegales de abuso sexual infantil hasta engañosos "deepfakes" políticos, está contaminando internet, y el CEO de Hive, Kevin Guo, cree que los sistemas de moderación de contenido de su empresa son un "antivirus moderno".

Utilizados por plataformas de redes sociales como Reddit y Bluesky, los sistemas de Hive emplean modelos de aprendizaje automático para identificar contenido dañino. Ahora, la startup estará mejor equipada para identificar y eliminar material de abuso sexual infantil (CSAM, por sus siglas en inglés) de los sitios web de sus clientes, gracias a una nueva asociación con la Internet Watch Foundation (IWF), una organización sin fines de lucro del Reino Unido dedicada a la protección infantil, anunció Hive este jueves.

Hive integrará los conjuntos de datos de la organización, que incluyen una lista actualizada regularmente de aproximadamente 8.000 sitios web que albergan imágenes confirmadas de CSAM tanto reales como generadas por inteligencia artificial, en sus modelos. El conjunto de datos también incluye una lista de frases únicas y palabras clave encriptadas utilizadas por los infractores para ocultar contenido de abuso sexual infantil y evadir la moderación.

Como parte del acuerdo, los clientes de Hive podrán acceder a los "hashes" de la IWF, huellas digitales de millones de imágenes y videos de CSAM identificados. La asociación se suma a la colaboración que Hive inició en 2024 con Thorn, una organización sin fines de lucro nacional que desarrolla tecnología para la detección de CSAM, con el objetivo de ampliar su alcance y eliminar más contenido violatorio de las plataformas de sus clientes.

La nueva alianza tiene como objetivo frenar la oleada de imágenes de abuso sexual infantil generadas por inteligencia artificial, de las cuales los infractores crearon decenas de miles en 2024. Las herramientas de IA generativa facilitaron aún más la producción de este tipo de material ilícito; en 2023, la IWF señaló a las autoridades más de 275.000 páginas web que contenían CSAM, un récord para la organización.

"El CSAM solía ser relativamente difícil de obtener. No es un contenido tan común", dijo Guo a Forbes. "Estos motores de generación de IA, tanto de imágenes como de videos, abren un mundo completamente distinto con la explosión de este contenido", agregó.

Fundada en 2014 como una aplicación de redes sociales, Hive cambió su enfoque en 2017 para vender sus herramientas internas de moderación a empresas. Actualmente, además de detectar contenido tóxico, los modelos de IA de la compañía pueden identificar logotipos, reconocer a decenas de miles de celebridades y detectar copias de películas y programas de televisión que se comparten en línea. La empresa, con sede en San Francisco, recaudó 120 millones de dólares en capital de riesgo de inversores como General Catalyst y fue valuada en 2.000 millones de dólares en 2021.

La amplia proliferación de contenido generado por IA impulsó el crecimiento comercial de Hive, cuya facturación se multiplicó por 30 desde 2020 (Guo prefirió no revelar las cifras actuales). La compañía procesa 10.000 millones de piezas de contenido cada mes para sus 400 clientes, que incluyen plataformas como la de streaming Kick, con unos 50 millones de usuarios, y el Pentágono. El mes pasado, Hive aseguró un contrato de 2,4 millones de dólares con el Departamento de Defensa de los Estados Unidos para garantizar que el contenido de audio, video y texto que su personal recibe de diversas fuentes sea real y confiable.

También hubo un creciente interés por parte de empresas de verificación de documentos y aseguradoras, que informaron un aumento en reclamos falsos. "Hay personas que tomaron una foto de su parachoques en un auto y la IA generó un rasguño", explicó Guo.

Más recientemente, tras la prohibición de TikTok, plataformas alternativas como Clapper y Favorited se inscribieron en los sistemas automatizados de moderación de contenido de Hive para prepararse ante la llegada masiva de "refugiados de TikTok", según Guo. "También estuvo incorporando proactivamente nuestras ofertas de CSAM, porque temen mucho que eso se convierta en un problema de alto perfil", precisó.

Guo no está preocupado por el enfoque laissez-faire del presidente Donald Trump respecto a la regulación de la inteligencia artificial. Aunque derogó la orden ejecutiva de la administración de Biden sobre IA, que establecía medidas para abordar los "deepfakes", la seguridad infantil en línea es un "tema bastante bipartidista", afirmó Guo. "No creemos que esta cuestión vaya a desaparecer", insistió.

*Con información de Forbes US.