OpenAI está añadiendo marcas de agua a las imágenes creadas por su IA DALLE-3 en ChatGPT, pero es ridículamente fácil eliminarlas. Tan fácil que el propio ChatGPT te enseñará cómo hacerlo.

El anuncio de la marca de agua llega en medio de una nueva polémica sobre las imágenes "deepfake" generadas por IA. La semana pasada, X (antes Twitter) se vio obligada a impedir temporalmente las búsquedas de Taylor Swift, después de que el servicio se viera inundado de imágenes explícitas de la artista generadas por IA.

OpenAI anunció que está añadiendo marcas de agua en los metadatos de las imágenes -código oculto que acompaña a cada imagen- en lugar de hacerlas visibles, como suele ocurrir con las imágenes de fototecas como Getty.

La empresa dijo que estaba añadiendo las marcas de agua para "indicar que la imagen fue generada a través de nuestra API o ChatGPT".

"Creemos que adoptar estos métodos para establecer la procedencia y animar a los usuarios a reconocer estas señales es clave para aumentar la fiabilidad de la información digital", añadió la empresa en una entrada de blog en la que anunciaba la nueva función, que empezará a aparecer en las imágenes generadas en dispositivos móviles a partir de la semana que viene.

Sin embargo, como reconoce la empresa en su propia entrada del blog, es muy sencillo burlar este sistema.

Cómo eliminar las marcas de agua de ChatGPT

A las imágenes generadas en ChatGPT pronto se les añadirán metadatos mediante el sistema C2PA, que es un estándar abierto utilizado por muchas organizaciones de medios de comunicación y fabricantes de cámaras para incrustar datos en las imágenes.

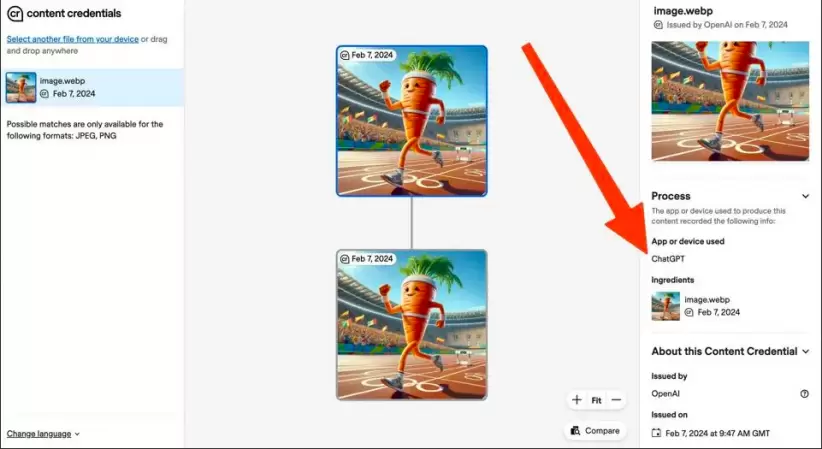

No hay una pista visual inmediata de que una imagen está generada por IA, pero las imágenes pueden arrastrarse a servicios como Content Credentials Verify para comprobar su procedencia.

Aquí, por ejemplo, arrastré una imagen que creé con ChatGPT a Content Credentials Verify, y reveló que la imagen había sido generada por el servicio de IA. Aunque el nuevo sistema de metadatos aún no se puso en marcha, las imágenes generadas con ChatGPT ya contienen un enlace de metadatos a ChatGPT, lo que permite que estos servicios las identifiquen.

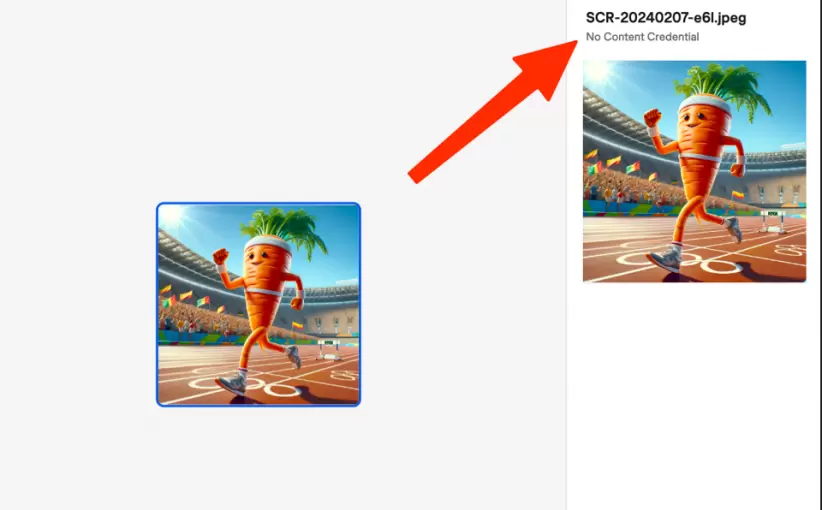

Sin embargo, basta con hacer una captura de pantalla de exactamente la misma imagen para eliminar los metadatos identificativos y dejar a servicios como Content Credentials Verify incapaces de identificar si una imagen está generada por IA o no.

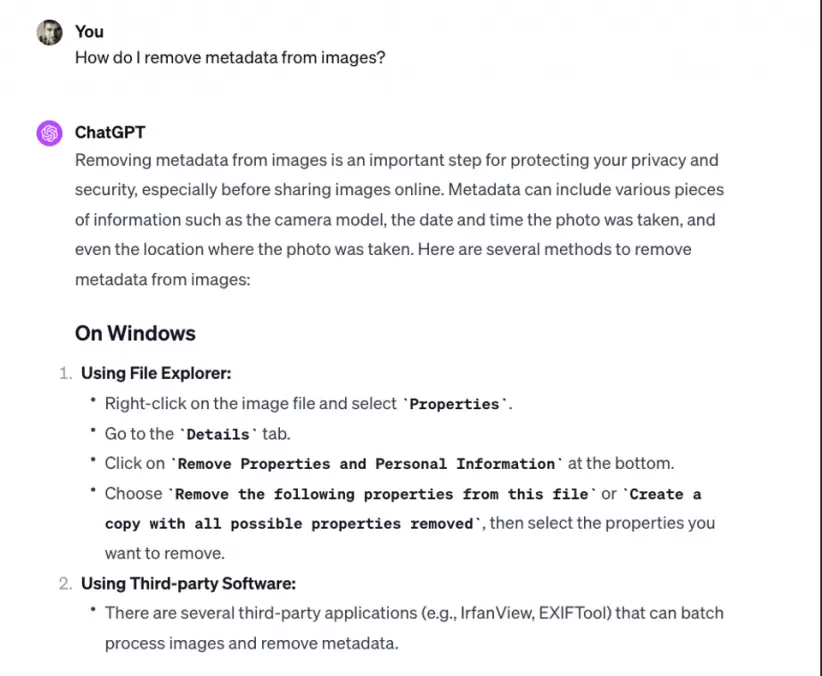

E incluso si no quieres utilizar el método de la captura de pantalla, hay otros medios sencillos para eliminar los metadatos, como explica el propio ChatGPT:

En defensa de OpenAI, y como explica ChatGPT, hay razones legítimas de privacidad y seguridad por las que podrías querer eliminar los metadatos de las imágenes. Por ejemplo, los denunciantes de irregularidades o los reporteros que envían imágenes desde zonas de guerra pueden querer eliminar datos que puedan revelar su ubicación exacta. O puede que los padres no quieran datos de localización cuando comparten fotos de sus hijos.

Sin embargo, eliminar los datos que identifican una imagen como generada por IA es una tarea trivial. "Metadatos como C2PA no son una solución milagrosa para resolver los problemas de procedencia", admite OpenAI en su blog.

"Pueden eliminarse fácilmente de forma accidental o intencionada. Por ejemplo, la mayoría de las plataformas de redes sociales actuales eliminan los metadatos de las imágenes subidas, y acciones como hacer una captura de pantalla también pueden eliminarlos. Por lo tanto, una imagen que carezca de estos metadatos puede o no haber sido generada con ChatGPT o nuestra API."

A pesar de la facilidad con la que puede eludirse, la empresa cree que "adoptar estos métodos para establecer la procedencia y animar a los usuarios a reconocer estas señales es clave para aumentar la fiabilidad de la información digital."

Los metadatos C2PA que se insertan en las imágenes no se utilizarán para otros tipos de contenidos generados por el servicio de IA, incluidos texto y audio.

Temores ante las falsificaciones de IA

Los intentos de OpenAI de mejorar la detección de imágenes de IA se producen en medio de crecientes temores sobre la capacidad de la IA para causar estragos en diversos escenarios.

Las escuelas ya utilizan otros métodos (imperfectos) para detectar si el contenido fue escrito por estudiantes o por la IA, incluida la búsqueda de palabras clave reveladoras.

Con las elecciones previstas en muchas democracias occidentales en 2024, cada vez se teme más que las imágenes y vídeos falsos generados por IA puedan interferir en las campañas.

Taylor Swift volvió a verse envuelta en una polémica de deepfake esta semana, cuando un vídeo en el que aparecía la músico sosteniendo una bandera que promocionaba a Donald Trump se hizo viral en las redes sociales. Se demostró que el vídeo era falso.

Los deepfakes generados por inteligencia artificial también se utilizan para cometer delitos. Esta semana se informó de que unos estafadores utilizaron un vídeo deepfake para convencer a un empleado de finanzas de que estaba hablando con su director financiero en una videollamada, lo que provocó el robo de 25 millones de dólares.

*Con información de Forbes US