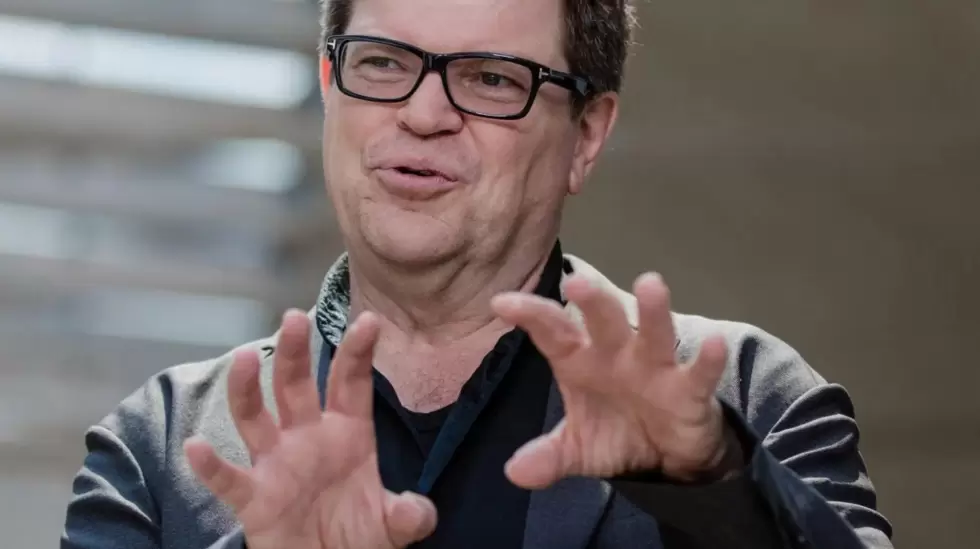

Yann LeCun, científico jefe de Meta, recuerda su reacción cuando OpenAI, entonces un rival menos conocido, lanzó ChatGPT el pasado noviembre. El chatbot, capaz de generar cartas de presentación, chistes, guiones y casi cualquier otro tipo de texto, incorporó la inteligencia artificial a la corriente dominante e inauguró una nueva moda en Silicon Valley.

Pero para LeCun, que puso en marcha el laboratorio de investigación de IA de Meta hace una década, la sorpresa no vino de la tecnología en sí: Meta llevaba años trabajando en los llamados grandes modelos de lenguaje, la tecnología subyacente de ChatGPT.

Apenas unas semanas antes, Meta había lanzado un chatbot similar llamado Galactica, específico para la redacción de artículos científicos. El software fue criticado en X, antes Twitter. Así que cuando ChatGPT fue tratado como "la segunda venida del mesías", tal y como lo describió LeCun a Forbes, se enfadó.

"La sorpresa fue que si ponés esta herramienta en manos de la gente, y si no viene de una gran empresa tecnológica, entonces la gente queda realmente impresionada por ella. Empiezan a utilizarla", explica LeCun. "Y el impacto que tuvo en la esfera pública y en la percepción pública, creo que fue una gran sorpresa para todos, incluida OpenAI".

Ese tipo de bagaje de gran empresa puede ser un riesgo ocupacional cuando trabajás para Meta, la matriz de Facebook. Durante años, se vio acosada por la polémica: interferencias en las elecciones, desinformación, perjuicios para el bienestar de los adolescentes. Los escándalos hicieron de Meta el blanco favorito de políticos y reguladores en Washington y erosionaron la confianza de muchos usuarios de sus plataformas. ¿También afectó a la percepción pública de la investigación de Meta?

"No, creo... quiero decir... sí", dijo LeCun, admitiendo el punto a mitad de frase. "Meta se está recuperando lentamente de un problema de imagen", dijo riendo. "Y, ya sabés, está mejorando. Desde luego, hay un poco de actitud negativa".

En cualquier caso, la carrera armamentística de la IA espoleada por ChatGPT inició una nueva era para el laboratorio FAIR de Meta. Lanzado como Facebook AI Research en 2013 (la F se cambió más tarde a "Fundamental" después de que la empresa se renombrara como Meta hace dos años), la unidad se propuso ser pionera en los avances científicos en inteligencia artificial. Diez años más tarde, cuando la IA se convirtió en la tecnología de moda en el sector, el laboratorio se convirtió en una de las divisiones más importantes de una de las empresas más poderosas del mundo.

"La sorpresa fue que si ponés esta herramienta en manos de la gente, y si no procede de una gran empresa tecnológica, entonces la gente queda realmente impresionada por ella".

-Yann LeCun

En el último año, en Meta se impulsó el uso de la IA como "núcleo" de los nuevos productos, en lugar de reforzarlos entre bastidores, dijo LeCun. Aunque el trabajo anterior del laboratorio se centraba en tareas como el reconocimiento de imágenes, el auge de la IA generativa inclinó la investigación en esa dirección.

En febrero, Meta presentó LLaMA, un gran modelo de lenguaje que rivaliza con GPT de OpenAI y que, hasta ahora, sirvió para potenciar herramientas de IA de Shopify y DoorDash. A lo largo de todo este proceso, FAIR se convirtió en un feroz defensor de la investigación de código abierto, un debate que estuvo haciendo estragos en todo el sector sobre las compensaciones entre la seguridad de la IA y el progreso potencial que conlleva la colaboración abierta.

Si todo va según lo previsto, pronto van a llegar más productos, sobre todo en lo que respecta a la multimillonaria inversión del CEO Mark Zuckerberg: el metaverso.

"Hay muchas pruebas de que el metaverso es la experiencia definitiva, inmersiva y generativa", afirma Joelle Pineau, Vicepresidenta de Investigación en IA de Meta. Describe mundos digitales repletos de personajes generados por IA, sus diálogos creados por LLM y entornos inmersivos diseñados con animaciones hechas por IA.

Es un futuro que Zuckerberg también proclamó en repetidas ocasiones. Pero el CEO de Meta también dijo que aún falta una década. Y en su iteración actual, el metaverso fue implacablemente ridiculizado, elogiado y declarado un error. "Mark sigue creyendo mucho en esa visión a largo plazo y ve el potencial de la IA", afirma Pineau.

Una "señal" de importancia

Zuckerberg y el antiguo director de tecnología de Facebook, Mike Schroepfer, pusieron en marcha FAIR en diciembre de 2013, recurriendo a LeCun, profesor de informática en la Universidad de Nueva York, para dirigir el proyecto.

El nuevo laboratorio tenía el "ambicioso objetivo a largo plazo de lograr grandes avances en Inteligencia Artificial", escribió LeCun en su lanzamiento. Zuckerberg y Schroepfer veían entonces potencial en la IA, gracias a avances recientes como AlexNet, una arquitectura de red neuronal seminal del informático Alex Krizhevsky, utilizada para el reconocimiento y la clasificación de imágenes.

En esos primeros días, el equipo de IA de la empresa se sentaba junto a Zuckerberg en el edificio 16 de la sede de Facebook. "El asiento no es casual", explica a Forbes Schroepfer, que dejó de ser director de tecnología en 2022. "Fue una señal de lo importante que era la IA para el futuro de la empresa". (Otros puestos de avanzada de FAIR incluyen Nueva York, donde LeCun tiene su sede, Montreal, Tel Aviv y Londres).

A lo largo de los años, FAIR hizo una serie de avances. PyTorch, un marco de aprendizaje automático lanzado en 2016, ayudó a los desarrolladores a crear modelos generativos de IA. Una tecnología llamada FastMRI, como su nombre indica, utilizaba IA para hacer resonancias magnéticas hasta 10 veces más rápidas. Otro sistema, llamado Few-Shot Learner, pretendía acabar con los contenidos nocivos de Facebook, como la desinformación sobre vacunas, en cuestión de semanas en lugar de meses.

Uno de los proyectos más llamativos de FAIR fue una iniciativa temprana de chatbot llamada M. En agosto de 2015, con mucha arrogancia, Facebook lanzó el servicio exclusivo a unas 2.000 personas en California. Se presentaba como un asistente milagroso que podía realizar casi cualquier tarea por vos, como hacer que le llevaran flores a tu madre o hacer reservas en un restaurante.

"Mark sigue creyendo mucho en esa visión a largo plazo, y ve el potencial de la IA".

-Joelle Pineau

Si el software parecía demasiado bueno para ser verdad en aquel momento, es porque lo era. Los algoritmos de inteligencia artificial de Facebook gestionaban un pequeño número de consultas de los usuarios, pero la inmensa mayoría de las tareas las realizaban contratistas humanos de forma analógica: llamando a la floristería para la entrega de flores o visitando manualmente la página web del restaurante para reservar la mesa.

"Existe la historia habitual de que quizá [el software] pueda hacer el 80% de lo que la gente quiere. Y es el último 20% lo que realmente le costará", explica LeCun a Forbes. "No fue así. Era peor".

El objetivo de M, según Facebook, era llevar a cabo un elaborado experimento para ver qué pediría la gente a los chatbots. Pero la compañía desconectó oficialmente el proyecto en 2018, y en la era de ChatGPT, el proyecto suena pintoresco.

M fue un ejemplo temprano de la intersección entre la investigación y la creación de productos, un punto de énfasis para el laboratorio desde el principio, dijo Schroepfer, y agregó que su mayor arrepentimiento relacionado con la IA como CTO fue no desplegar más chips de GPU para entrenar datos.

En un acto por su 10º aniversario celebrado el jueves, FAIR centró la atención en nuevos productos y herramientas, como Audiobox, que permite a los usuarios introducir en el sistema un mensaje de voz o texto y crear el correspondiente clip de sonido en función de sus preferencias de voz (por ejemplo, una persona con voz grave que suena frenética).

La empresa también presenta un nuevo conjunto de modelos de traducción de idiomas, llamado Seamless, incluido uno que conserva el tono, la cadencia y el volumen de la voz de una persona al traducir.

FAIR también anuncia un nuevo conjunto de datos de código abierto sobre videos grabados desde distintos puntos de vista. Una de las aplicaciones de estos datos podría ser la creación de videos de instrucciones sobre IA que incluyan múltiples perspectivas. El proyecto es una colaboración entre Meta y varias universidades, entre ellas Carnegie Mellon y la Universidad de Pensilvania.

Por último, la empresa presenta una herramienta llamada ROBBIE para ayudar a detectar sesgos en los modelos generativos del lenguaje, algo que preocupó mucho a otros investigadores y académicos. La herramienta compara las respuestas generadas por IA a partir de cinco LLM diferentes y busca sesgos en categorías como raza, tipo de cuerpo e ideología política. La idea es que los desarrolladores midan el daño potencial de las herramientas y "equilibren cualquier contrapartida", escriben los investigadores en un artículo.

Cosas sucias en tu armario

Uno de los mayores lanzamientos de FAIR se produjo en febrero, cuando la empresa presentó LLaMA, un potente modelo lingüístico para competir con GPT de OpenAI y los modelos LaMDA y PaLM de Google. Pero a diferencia de sus rivales, LLaMA 2, la siguiente generación del modelo, es de código abierto. La decisión vino directamente de Zuckerberg, dijo LeCun, tras un "gran debate interno".

Esa presentación calificó a Meta y FAIR como uno de los defensores más acérrimos de un enfoque de código abierto para la investigación, en el que la empresa publica su código y lo pone a disposición de usuarios e investigadores externos. "La idea es empezar cada proyecto con la intención de abrir el código", afirma Pineau. "Si mantienes las cosas cerradas, es fácil que guardes muchas cosas sucias dentro de tu armario".

Pero aunque el código abierto es una de las claves de FAIR, añade que no es una "religión", y que la empresa decide su enfoque en función del proyecto. El nuevo modelo Audiobox de Meta, por ejemplo, sólo está abierto a un número limitado de investigadores que solicitan utilizarlo.

En todo el sector tecnológico, el debate sobre el código abierto adquirió un tenor acalorado. Por un lado, empresas como Meta, Hugging Face y Mistral practicaron la transparencia, en nombre de la colaboración y el progreso científicos, y evitaron los sistemas de caja negra envueltos en el secretismo.

En el otro lado están empresas como OpenAI (a pesar de su nombre) y DeepMind de Google. El argumento a favor de un sistema cerrado gira en torno a reducir los riesgos de seguridad, evitando el abuso por parte de malos actores que pongan sus manos en el código.

La Casa Blanca, por ejemplo, advirtió contra los modelos de IA de código abierto que ayudan a la biología sintética y podrían crear la próxima pandemia. (El vertiginoso golpe de estado de la junta directiva de OpenAI la semana pasada, en el que el CEO Sam Altman fue destituido y luego reintegrado en el torbellino de cinco días, se debió en parte a las supuestas preocupaciones de seguridad planteadas por el científico jefe de OpenAI, Ilya Sutskever).

"A diferencia de otros que quizá tengan cierto complejo de superioridad, no creemos tener el monopolio de las buenas ideas".

-Yann LeCun

Connor Leahy, CEO de Conjecture, una startup londinense dedicada a la seguridad de la IA, cree que Meta es el más irresponsable de los principales actores de la IA por su enfoque ampliamente abierto. "¿Deberíamos ser transparentes sobre el diseño de las armas nucleares?

LeCun rechaza estas críticas. "Los sistemas que tenemos son aún muy primitivos", afirma. "Así que creo que los beneficios superan con creces los riesgos que conlleva el código abierto".

En cambio, DeepMind, de Google, es más reservada con su código y sus investigaciones. LeCun se enfrentó al fundador de DeepMind, Demis Hassabis, en X, acusándolo de "alarmismo" en su presentación de la regulación de la IA.

Hassabis se opuso a LeCun, afirmando que las empresas deben gestionar los riesgos antes de que los sistemas se conviertan en peligrosos. Preguntado por el enfoque de DeepMind, LeCun se reafirmó. "Se está convirtiendo en una empresa cada vez menos abierta", dijo, una crítica a la que DeepMind se enfrentó a medida que Google fue integrando el laboratorio más estrechamente en el resto de la empresa. "Creo que va a retrasar el progreso en todo el campo. Así que no estoy muy contento con esto".

Aunque FAIR predica el código abierto, algunos críticos sostienen que Meta sólo se preocupa por sus propios intereses comerciales, lanzando intencionadamente burlas a Google y OpenAI. Preguntado por esa teoría, LeCun dijo rotundamente: "No".

"Esa no es la motivación. La motivación es que tenemos que hacer progresos. Y necesitamos que toda la comunidad investigadora contribuya a ello", dijo. "A diferencia quizás de otros que puedan tener algún complejo de superioridad, no creemos que tengamos el monopolio de las buenas ideas".

Amanda Carl, vocera de Google DeepMind, defendió las contribuciones del laboratorio a la comunidad de código abierto, señalando la infraestructura y las herramientas para desarrolladores, incluido el transformador, la tecnología que sustenta los LLM, y TensorFlow, una plataforma de aprendizaje automático. "Nuestro historial de código abierto habla por sí solo", afirma Carl en un comunicado.

Para Meta, el nuevo escenario de la IA puede resaltar viejos problemas, dijo un antiguo empleado de Facebook, que trabajó con el equipo de FAIR. "La IA no es más que un nuevo marco de imagen sobre los mismos desafíos y preocupaciones en torno a la seguridad, la moderación de contenidos y el bienestar", dijo a Forbes el empleado, que pidió el anonimato para proteger sus intereses profesionales en el sector. "Todo seguirá amplificándose con la IA".

Mientras tanto, el papel de la IA en Meta sigue creciendo, y el entusiasmo captó la atención de Zuckerberg. "Estuvo muy, muy involucrado en la creación de FAIR hace 10 años", dijo Pineau. "Luego estuvo mucho menos implicado durante muchos años. Y ahora vuelve a estar muy implicado".

*Con información de Forbes US